本文目录

本篇内容来自AI

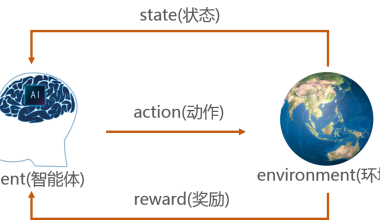

在具身智能领域,强化学习(RL)与运动规划(Planning)的关系并非简单的“替代”或“缩水”,而是呈现出融合与互补的趋势。以下从技术逻辑、实际应用和发展趋势三个层面展开分析:

一、技术本质:强化学习与运动规划的核心差异

| 维度 | 运动规划(传统Planning) | 强化学习(RL) |

|---|---|---|

| 决策逻辑 | 基于预先建模的环境约束(如地图、运动学方程),通过数学优化求解确定路径/轨迹。 | 从环境交互中通过试错学习策略,无需显式建模,依赖奖励函数驱动决策。 |

| 适应性 | 对已知环境高效,但面对动态变化或未知场景时需重新规划。 | 可自主适应未知环境,但初期训练需大量样本,收敛速度依赖算法设计。 |

| 计算复杂度 | 确定性算法(如A*、RRT)计算量可控,适合实时性要求高的场景。 | 随机性策略搜索(如PPO、SAC)计算量较大,需高性能算力支持训练。 |

二、强化学习对运动规划的影响:并非替代,而是拓展边界

1. 在复杂场景中,RL为Planning提供“智能优化”

- 传统Planning的痛点:在非结构化环境(如家庭杂物场景、动态障碍物场景)中,显式建模成本高,路径规划可能陷入局部最优(如机器人在复杂家具间反复避障)。

- RL的补充作用:通过训练机器人直接学习“如何在未知环境中高效移动”,例如:

- Google DeepMind的「移动机器人导航」研究中,RL策略可自主学习避开动态行人,而传统规划算法需预先设定行人运动模型。

- 机械臂抓取任务中,RL可优化抓取姿态(如角度、力度),而传统轨迹规划仅能完成“从A到B”的路径生成,无法自适应物体表面特性。

2. 在实时性场景中,Planning仍是RL的“底层支撑”

- RL的局限性:纯RL决策可能因环境随机性导致动作震荡(如机器人在障碍物前反复试探),无法满足工业场景毫秒级响应需求。

- Planning的不可替代性:

- 热启动(Warm Start):RL策略可调用Planning生成的初始路径作为“先验知识”,减少训练样本量。例如,特斯拉Optimus机器人在行走时,先用SLAM构建地图,再通过RL优化步态。

- 安全兜底:传统规划中的碰撞检测(如OBB包围盒算法)可作为RL的安全约束,避免机器人在训练中“试错”导致硬件损坏。

三、前沿趋势:RL与Planning的深度融合架构

1. 分层决策框架:RL负责策略,Planning负责执行

- 案例:OpenAI的Dactyl机器人训练中,上层RL学习“抓握策略”(如判断物体形状选择抓取点),下层通过运动规划生成机械臂关节轨迹,确保动作可行性。

- 优势:结合RL的环境适应性和Planning的运动学约束,平衡“智能性”与“可行性”。

2. 神经符号融合:用RL优化Planning的参数

- 技术路径:通过神经网络(如Transformer)学习环境特征,再将特征输入传统规划算法(如RRT*),动态调整规划参数(如扩展步长、采样密度)。

- 应用:MIT的「神经规划器」可根据视觉输入自动调整路径规划的采样策略,在复杂场景中比传统RRT快30%。

3. 模仿学习+规划:从人类示范中学习“规划逻辑”

- 方法:通过模仿学习(IL)让机器人学习人类专家的规划思路(如优先选择最短路径、规避危险区域),再结合传统规划算法生成动作。

- 案例:斯坦福AI实验室的「自动驾驶规划系统」,用IL学习人类司机的决策偏好,再用轨迹规划算法生成安全路径。

四、结论:RL不会让Planning缩水,而是推动其“智能化升级”

- 短期:传统运动规划仍是具身智能的基础,尤其在工业、医疗等对安全性和实时性要求极高的场景中不可替代。

- 长期:RL将成为规划的“智能引擎”,通过学习优化规划策略、参数和约束,使机器人在未知环境中具备更接近人类的“直觉决策”能力。

- 建议:作为从业者,可同时掌握传统规划算法(如ROS中的OMPL库)和RL框架(如Stable Baselines3),并关注神经符号系统、分层强化学习等前沿方向,以适应技术融合趋势。